AI 生圖細(xì)思極恐,連它自己也分辨不出真假了

北京時(shí)間 4 月 12 日消息,人工智能(AI)圖像生成器的技術(shù)正在迅速發(fā)展,它不但能夠蒙蔽人類,就連專門用于查圖的 AI 工具也未必能分辨真假。

今年 1 月時(shí),OpenAI 的 AI 文字圖片生成模型 DALL-E 等系統(tǒng)還不夠先進(jìn),只能渲染出一個(gè)手指向后傾斜或多余眉毛在漂浮的人類。但是到了 3 月,一些圖片已經(jīng)逼真到足以欺騙很多人。

上圖是一張由微軟必應(yīng)圖像生成器生成的圖片,里面有 6 個(gè)破綻,相對(duì)容易分別。如果不看標(biāo)記,你能找出這 6 個(gè)圖片漏洞嗎?

1.她的手指極長(zhǎng)且扁平。

2.她的嘴巴似乎少了幾顆牙齒,陷進(jìn)了她的臉。

3. 她的手進(jìn)入了桌子里。

4. 他的手指又長(zhǎng)又扁。

5.她的襯衫下垂不自然。

6.桌子上的物品混合在一起。

但是,有些 AI 生成的圖片已經(jīng)達(dá)到了以假亂真的地步了。例如,特朗普被捕的圖片,教皇方濟(jì)各穿上巴黎世家白色羽絨服的照片,法國(guó)總統(tǒng)馬克龍穿過抗議人群的照片。

如果不是有人提醒,你可能很難看出這是假圖片。這就是為什么埃隆?馬斯克(Elon Musk)等科技領(lǐng)袖呼吁暫停 AI 開發(fā)等原因。雖然 AI 生成的內(nèi)容可能很有趣,但它會(huì)給行業(yè)和日常互動(dòng)帶來風(fēng)險(xiǎn)。它可以被用來傳播錯(cuò)誤信息、侵犯知識(shí)產(chǎn)權(quán)。

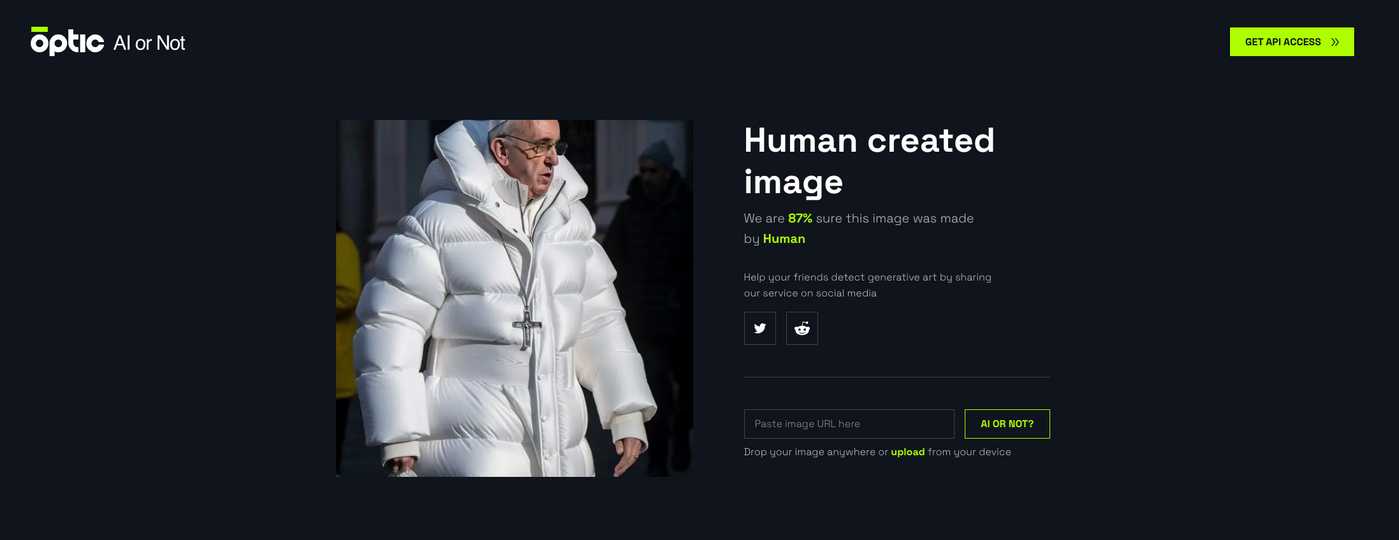

一些開發(fā)人員正在開發(fā)工具,通過分析圖像以尋找人工智能做圖跡象的工具。但問題是,除非這些工具與它們所監(jiān)視的圖像生成器保持同步,否則即使是它們也可能被愚弄。例如,AI 信任和安全公司 Optic 的工具就被欺騙了,它認(rèn)為有 87% 的可信度相信教皇穿著巴黎世家羽絨服的圖片是人類拍攝的。

標(biāo)簽(TAG)